Autor: Alejandro Neri Rendón

Titulo: Sistemas de Comunicación

Area:

Pais:

Perfil:

Programa:

Disponible para descarga: Yes

Ver Más Publicaciones Estudiantiles Clic aquí

Diseminar información, ideas innovadoras y conocimientos académicos es una función importante para Atlantic Internacional University. Publicaremos noticias, artículos, comentarios y otras publicaciones de nuestros estudiantes y otros colaboradores. Si desea contactar al autor por motivos profesionales favor enviar su petición por este medio.

Para conocer más de la iniciativa de Acceso Abierto de AIU haga Clic aquí.

INTRODUCCIÓN

1 PROLOGO:

Este trabajo es producto del diplomado de Calculo de Enlace Satelital que decidí cursar con la finalidad de dominar los enlaces vía microondas y satelital, necesarios para desarrollar mi trabajo, así mismo aproveche para desarrollar la materia (sistemas de Comunicación) propuesta en mi plan de estudios.

En la actualidad las comunicaciones han tomado tal fuerza y principalmente en la institución donde trabajo es de vital importancia realizar este tipo de enlaces para cubrir eventos de carácter cultural y educativo como por ejemplo el cervantino que se realiza en el estado de Guanajuato el cual tiene importancia mundial, y La Dirección General de Televisión Educativa (DGTVE), la cual es dependencia de la SEP, y tiene la responsabilidad de difundir a través de señal satelital canales culturales y educativos así como también la señal para Telesecundaria y Telé bachillerato. Es aquí donde participa la DGTVE y el departamento de Ingeniería donde colaboro, este departamento es responsable de realizar toda la instalación del equipo de producción televisiva y enlazarla para su transmisión vía satélite.

La importancia de transmitir la señal de televisión Educativa a las escuelas es fundamental por que es la única forma que tienen los niños e incluso los adultos de estudiar y tener un contacto con el mundo. En México por su geografía y economía no es fácil que cada población tenga escuelas con maestros por lo cual una solución alterna es la de tele secundaria y para que esto sea posible se tiene que instalar un sistema compuesto de una antena receptora un receptor o sintonizador satelital y una televisión además de la instalación eléctrica y en lugares donde no hay energía se instala un sistema fotovoltaico, de esta forma gran parte de la población rural que cursa sus estudios de primaria, secundaria, tele bachillerato e incluso diplomados de especialización logran hacerlos mediante programas de televisión transmitidos desde la capital.

Al estar en el área de Ingeniería mi responsabilidad es la de no solo mantener funcionando el equipo sino también establecer las líneas de comunicación para poder llevar la señal de un punto a otro por tal motivo es obligatorio el dominio de la teoría y practica sobre enlace satelital y microondas.

El diplomado estuvo compuesto por la teoría de las comunicaciones satelitales y la practica donde se realizaron ejercicios y resolvieron problemas así como también se estudiaron los principales elementos a considerar para un correcto enlace satelital cabe aclarar que el calculo de enlace satelital requiere de un seguimiento y calculo matemático preciso para tener una correcta comunicación, de lo contrario un error podría desde no lograr la comunicación y en el caso mas extremo dañar el Transponder del satélite estaríamos hablando de que el daño seria catastrófico debido al costo y tiempo que implica poner un satélite en órbita por lo cual no se puede dar uno el lujo de cometer errores así mismo se tiene que hacer un correcto análisis de los requerimientos para realizar una comunicación satelital esto es desde que satélite se va a utilizar cual es su cobertura y ancho de banda así como el costo y tiempo de la transmisión, después de estos datos se necesita considerar si se requiere comprar el equipo de transmisión hablamos de antenas (High-Power Amplifiers HPA) receptores transmisores medidores y sistemas de audio y video o datos, o en caso de ser eventual rentarlo, la obligación de el ingeniero encargado del enlace es la de analizar el equipo y geografía y a partir de este punto realizar un calculo que implica elegir el equipo adecuado considerar las condiciones meteorológicas y el Transponder por el cual se realizara el satélite así mismo se tiene que contactar con la empresa dueña del satélite para rentar el servicio llevando previo todo el calculo que implica hablamos de equipo que se utilizara lugar fecha y hora así como la potencia a la cual se enviara la señal al satélite y al mismo tiempo tener la potencia y atenuación con la que se recibirá. De la experiencia adquirida se desarrollo el siguiente trabajo.

2 INTRODUCCION:

El propósito del presente trabajo, tiene como finalidad establecer una comparación entre los sistemas de compresión digital como son La tecnología DigiCipher y el estándar (Digital Video Broadcasting DVB), a fin de satisfacer las necesidades que requiere la Dirección General de Televisión Educativa para el proceso de Migración Tecnológica que está llevando a cabo la DGTVE, reflejando con ello la mayor optimización del Recurso satelital.

Esto pretende ayudar a una mayor difusión de la educación, logrando ampliar la cobertura de la red Edusat, así como la programación (pues se podrá tener hasta 16 canales de Televisión de calidad digital) y el contenido de los programas.

Ahora bien, con el fin de dar a conocer los conceptos necesarios que se encuentran implícitos dentro del Proceso de Migración Tecnológica de la Red Edusat, que se lleva a cabo dentro de la Dirección General de Televisión Educativa, se recopiló la Presente información con el fin de cubrir los siguientes objetivos:

Aspectos Generales: Proporcionar los conocimientos precisos sobre los temas de comunicaciones vía satélite.

Sistemas de Transmisión para señales de Televisión: Presentar de manera precisa la Información necesaria sobre Televisión Analógica, Televisión Digital y algunos de los estándares de compresión digital.

Realizar la revisión general del Estándar seleccionado por la DGTVE para la migración Tecnológica; es decir verificar el funcionamiento de algunos equipos de recepción digital con estándar DVB.

Facilitar a través de este documento, la capacitación y aprendizaje de técnicos e ingenieros, de los conceptos que se encuentran inmersos dentro de la Migración Tecnológica.

La presente información integra contenidos que dan respuesta a interrogantes como ¿para qué sirve y qué elementos integran los sistemas de transmisión recepción de señales vía satélite? ¿Cuáles son los sistemas de compresión empleados en la Red Edusat? y ¿qué es el Estándar DVB? La solución a estas y otras preguntas permitirá hacer de este material una herramienta de apoyo invaluable para el desarrollo de futuros ingenieros y técnicos en telecomunicaciones. Este material constituye una lectura obligada para quien pretenda emplear Sistemas de Transmisión de señales vía satélite, ya que abarca desde tópicos muy generales que permiten comprender los conceptos básicos de las comunicaciones vía satélite, revisa los conceptos básicos de las transmisiones de señales vía satélite, televisión digital y analógica, pasando por una sólida revisión de todos y cada uno de los componentes de los Sistemas de televisión analógica y digital, hasta temas muy especializados de Sistemas de compresión, Calculo de enlaces, El estándar DVB, entre otros.

3 ANTECEDENTES:

En el transcurso de los últimos años, el empleo de las nuevas tecnologías de la comunicación y la informática han permitido mejorar la calidad de la Educación, como también extender y promover en forma continua la cobertura de los servicios a poblaciones pequeñas, dispersas y de difícil acceso, así como a las de gran magnitud. Pese a los avances logrados hasta ahora, el desarrollo desigual de nuestro país ha impedido que los beneficios educativos alcancen a toda la población. Hoy en día persisten numerosos niños, adolescentes y jóvenes que aún no son atendidos por el Sistema Educativo.

La mayor parte de la población, que permanece al margen de los servicios educativos, habita en las localidades más alejadas y dispersas del territorio nacional o en alguna de las zonas urbanas marginadas del país o bien pertenece a alguna etnia indígena, que por lo general se encuentra en condiciones de pobreza extrema.

Pese a los grandes esfuerzos que se han realizado en los últimos años por aumentar la cobertura de los servicios educativos del nivel básico, se han encontrado condiciones muy desfavorables, ya que existen comunidades con carencia de servicios elementales, las cuales no ofrecen las posibilidades del desarrollo y acentúa el rezago educativo existente.

En estas condiciones, el Programa Nacional de Educación (PNE) 2007-2012 tiene entre sus objetivos estratégicos avanzar hacia la equidad en la educación y proporcionar una educación de calidad adecuada a las necesidades de todos los mexicanos.

En este PNE 2007-20012, se establece la política de fomento al uso educativo de las tecnologías de la información y comunicación en la educación básica, con lo que se impulsarán el uso, expansión y desarrollo de las tecnologías de la información y la comunicación, así como la producción de materiales audiovisuales e informáticos que favorezcan el aprendizaje.

La Dirección General de Televisión Educativa (DGTVE), dependiente de la Secretaría de Educación Pública, es la responsable de llevar a cabo las acciones necesarias y cumplir las metas que en este sentido compromete el PNE 2007-2012. En Diciembre de 1995, el Gobierno Federal a través del Programa de Modernización para la educación 1989-1994 creó la Red de Educación vía Satélite (Edusat), para dar respuesta a la creciente demanda del servicio educativo del país, así como al rezago en las poblaciones más dispersas y alejadas del territorio

Nacional utilizando la televisión.

Con este sistema de televisión educativa se pretende atender las necesidades de alfabetización, capacitación, educación básica, media superior, superior técnica y tecnológica de las cuales la Secretaría de Educación Pública es órgano rector.

La Red Edusat opera actualmente a través de los satélites Solidaridad II, el cual cubre en su totalidad la República Mexicana, el sur de Estados Unidos, Centroamérica y el Caribe; y el satélite SATMEX 5 que cuenta con una cobertura continental y próximamente se migrara del satélite solidaridad II al satmex 6.

Este sistema tiene una capacidad de operación, en este momento, de Ocho canales básicos de televisión, cuatro administrados por la Dirección General de Televisión Educativa (DGTVE) 11, 12, 14 y 17 y cuatro por el Instituto Latinoamericano de la Comunicación Educativa (ILCE) 13, 15, 16 y 18 que transmiten las 24 horas de los 365 días del año.

Cabe destacar que la Red Edusat emplea el sistema de compresión digital, conocido como Tecnología DigiCipher en sus dos versiones: DigiCipher I (DC I) y DigiCipher II (DC II). Esta tecnología es propiedad de Motorola, la cual tiene más de 8 años en funcionamiento. Se considera, por lo tanto, un sistema cerrado porque requiere de actualización y renovación exclusiva de Motorola y sus costos son elevados al no haber otro fabricante de estos equipos. Actualmente la Red Edusat cuenta con aproximadamente 33,000 sistemas de recepción instalados en distintas instituciones tales como:

Telé secundarias

Secundarias técnicas

Secundarias generales

Primarias

Centros de educación indígena

Centros de maestros

Institutos tecnológicos estatales

Universidades

Campos militares de SEDENA

Centro de readaptación social (CERESO)

Instituto Federal Electoral en los estados

Hospitales

Consejo Nacional de Fomento Educativo (CONAFE)

Instituto Nacional para la Educación de los Adultos (INEA)

El Sistema Edusat no sólo es una herramienta para fortalecer el trabajo del docente y apoyar el aprendizaje de los alumnos, es también una opción para enriquecer la formación cotidiana de la población en general. Esto gracias a que en sus canales se transmite una programación variada que incluye entre otros programas de educación curricular para distintos niveles educativos, programas complementarios al currículo, programas de actualización docente, programas de capacitación, así como diversas series educativas dirigidas a todo público; todos éstos pretenden el desarrollo integral de las personas.

Para aprovechar al máximo las potencialidades del equipo y en consecuencia los servicios educativos que la Red Edusat ofrece, la DGTVE ha implementado el Programa de Migración y Convergencia Tecnológica con el que se pretende sustituir a todo lo largo y ancho de la República mexicana toda la Tecnología DigiCipher (DC I y DC II) por la Tecnología DVB, con el fin de proporcionar un sistema más abierto y una mayor cobertura de la educación en México, además de renovar y modernizar el sistema de transmisión de la Red Edusat.

Este material constituye una lectura obligada para quien pretenda emplear Sistemas Satelitales, ya que abarca desde tópicos muy generales que permiten entender los diferentes tipos de sistemas de compresión empleados en la Red Edusat, revisa los conceptos básicos de Sistemas de Comunicación vía satélite, pasando por una sólida revisión de todos y cada uno de los componentes de los Sistemas de televisión tanto analógicos como digitales, hasta temas muy especializados como lo son el de: “El Estándar DVB” y el Calculo de enlaces Satelitales para banda C.

4 SATÉLITES EMPLEADOS

SATÉLITES MEXICANOS: México cuenta con dos sistemas de satélites, entre los cuales se incluye el sistema de satélites Morelos (I y II). Actualmente tiene en funcionamiento los Sistemas Solidaridad (I, perdido en Agosto 27 del 2000, y II) y los Satmex (5 y 6). Con estos satélites se tiene cobertura en el Continente Americano incluyendo la parte sur de Canadá. Actualmente la Red Edusat emplea los satélites Solidaridad II y Satmex 5. A raíz de la pérdida del solidaridad I, se emplea el Satmex 5 para cobertura Continental y el solidaridad II para la cobertura nacional este último será sustituido por el Satmex 6. Los satélites mexicanos se encuentran en un área llamada órbita geoestacionaria, la cual se ubica a aproximadamente 36,000 km de distancia de la tierra sobre el plano del Ecuador. El satélite Solidaridad I operaba en una longitud de 109.2° Oeste, la cual emplea el Satmex 6; el Solidaridad II se encuentra en una longitud de 113.0° Oeste y el Satmex 5 en una longitud de 116.8° Oeste, con referencia al meridiano de Greenwich.

|

SATÉLITE |

TRANSPONDER |

FREC. DE SUBIDA. |

FREC. DE BAJADA |

DC I |

SOLIDARIDAD II |

3N |

6.025 GHz |

3.800 GHz |

DC II |

SATMEX 5 |

24 C |

6.405 GHz |

4.180 GHz |

Tabla1

SATELITES SOLIDARIDAD

El sistema de satélites Solidaridad representa la segunda generación de comunicaciones espaciales para México (Se debe de recordar que el satélite Solidaridad I ya no esta en operación). En forma similar a los satélites Morelos, cada uno de los Solidaridad cuenta con 18 Transponders en banda C, pero con mucho mayor potencia que los primeros, y cobertura en más áreas geográficas, gracias a la tecnología de amplificadores de estado sólido (Solid State Power Amplifier SSPA) empleados en su construcción. Asimismo, dentro de la carga útil se cuenta con 16 Transponders de banda Ku equivalentes a 4 veces la capacidad que se tenía en los Morelos. Adicionalmente existe un sistema de transmisión en banda L, que permite dar servicios de comunicación móvil a todo el país, incluyendo sus costas y mar territorial.

Todas las bandas cubren México, además de las extensiones en banda Ku para coberturas en la frontera sur de los Estados Unidos, la costa Este y las ciudades de San Francisco y Los Ángeles. La cobertura en banda C se extiende hacia el Caribe, Centro y Sudamérica.

ESPECIFICACIONES SOLIDARIDAD II |

|||

Solidaridad II |

36 MHz Banda C |

72 MHz Banda C |

54 MHz Banda Ku |

PIRE (dBW) |

R1: 37.0 |

R1: 40.1 |

R4: 47.0 |

G/T (dB/°K) |

R1: 4 |

R1: 2 |

R4: 2 |

Densidad de flujo a saturación |

R1: -93 |

R1: -91 |

R4: -94 |

No. de Transponders |

12 |

6 |

16 |

Redundancia |

14 SSPAs para 12 canales |

8 SSPAs para 6 canales |

19 TWTAs para 16 canales |

Rango de atenuación de entrada |

0 a 14 dB en pasos de 2 dB |

0 a 14 dB en pasos de 2 dB |

0 a 22 dB en pasos de 2 dB |

Inicio de operación |

Diciembre de 1994 |

|

|

Vida estimada de operación |

14 años |

|

|

Tabla2

El DVB (Digital Video Broadcasting) es un organismo encargado de crear y proponer los procedimientos de estandarización para la televisión digital compatible. Está constituido por más de 270 instituciones y empresas de todo el mundo. Los estándares propuestos han sido ampliamente aceptados en Europa y casi todos los continentes, con la excepción de Estados Unidos y Japón donde coexisten con otros sistemas propietarios. Todos los procedimientos de codificación de las fuentes de vídeo y audio están basados en los estándares definidos por MPEG

EN EL SATELITE SOLIDARIDAD 2

TRANSPONDER 3N

36

Figura 2

COBERTURAS

Cobertura Satélite Satmex 5

Cobertura Satélite Solidaridad II

BANDA C1 Figura 7 |

BANDA C2 Figura 8 |

KU 5 Figura 9

5 CONCEPTOS GENERALES DE COMUNICACIONES

TIPOS DE SISTEMAS DE COMUNICACIÓN

Se denomina “Sistema” al conjunto de componentes o dispositivos del mundo físico que interactúan entre sí, que aceptan señales como entradas, las transforman y generan otras señales a su salida. En la figura 10 se representa a bloques la entrada al sistema, el sistema que transforma la señal de entrada y la salida del sistema, respectivamente.

SEÑAL DE ENTRADA------>SISTEMA DE COMUNICACION------>SEÑAL DE SALIDA

Figura 10

Existen dos tipos básicos de sistemas de comunicación electrónica, analógica y digital. Los sistemas de comunicación analógica son en los que se transmite y recibe la energía electromagnética en forma analógica (una señal variando continuamente tal como una onda senoidal), los sistemas de radio y televisión comerciales emiten señales analógicas. Los sistemas de comunicación digital son en los que transmite y recibe la energía electromagnética en forma digital (niveles discretos tal como + 5 v y tierra), los sistemas binarios utilizan señal digital que solo tienen dos niveles discretos. Estos sistemas pueden transmitir o recibir la señal en forma alámbrica e inalámbrica.

6 COMUNICACIÓN SATELITAL

La comunicación por satélite moderna ha sido posible a una combinación de ciencia y tecnología espacial, cada año se ponen en órbita satélites más eficientes y complejos, a un costo cada vez menor. La comunicación por satélite es uno de los negocios que más eficazmente a evolucionado en el mundo de las telecomunicaciones.

Satélite: es un cuerpo celeste animado de un movimiento de translación en torno generalmente, de un planeta, existen dos tipos naturales y artificiales.

DEFINICIÓN DE SATÉLITE ARTIFICIAL

Es un elemento físico que esta colocado en órbita por las necesidades que tiene el hombre para recibir y transmitir información a cualquier punto de la Tierra.

La mayoría de los satélites de comunicación son colocados en el cinturón de Clarke, esto significa que se encuentra en el arco Geosincrónico, a una altura sobre el ecuador de 35.00 km. La velocidad de los satélites artificiales es igual a la de la rotación terrestre y giran sobre su propio eje, por ello, cada satélite aparece inmóvil con respecto a la Tierra, permitiendo que las antenas fijas apunten directamente hacia cualquier satélite específico.

Un satélite es un elemento capaz de recibir y transmitir datos, audio y vídeo en forma analógica o digital de alta calidad. Está formado por Transponders. El satélite toma su energía de la luz del sol. Cada satélite tiene un tiempo de vida determinado, el cuál varía según la cantidad de combustible que posee. Dicho combustible sirve para mover al satélite cada vez que éste se sale de su órbita. Si el satélite pierde su posición y no tiene combustible, no hay manera de regresarlo y es atraído por las fuerzas espaciales, perdiéndose. El satélite tiene un margen bien determinado en el espacio. Es un cubo imaginario de aproximadamente 75 Km por lado, si el satélite se mueve dentro de ese cubo sin salirse de el no se presenta cambio alguno en la señal.

Figura 11

Los sistemas que posibilitan el funcionamiento de un satélite son:

Antenas:

Posibilitan la recepción y la transmisión de las señales de radiofrecuencia.

Comunicaciones:

Amplifican las señales y cambian su frecuencia.

Energía eléctrica:

Suministran electricidad con los niveles adecuados de voltaje.

Control térmico:

Es el que regula la temperatura del conjunto.

Posición y Orientación:

Determina la posición y orientación del satélite.

Propulsión:

Proporcionar incrementos de velocidad y pares para corregir la posición y la orientación.

Rastreo, telemetría y comando:

Intercambian información con el centro de control en tierra para conservar el funcionamiento del satélite.

Estructural:

Alojan todos los equipos y le da rigidez al satélite.

Las principales características de funcionamiento de un satélite son:

Recibir y transmitir señales. Aumentar la potencia de las mismas: Este proceso es indispensable, ya que sin una potencia suficiente la información llegaría en forma deficiente o simplemente no llegaría.

Disminuir la Frecuencia e invertir la Polaridad: Son dos maneras de evitar que las señales, tanto de ascenso como de descenso se interfieran y existan pérdidas en la información

Un satélite denominado "Geoestacionario", gira alrededor de la tierra a la misma velocidad angular que nuestro planeta sobre su eje. Su posición está determinada siempre por una latitud 0º y una longitud de acuerdo a su posición.

Longitud 0º = meridiano de Greenwich

Latitud 0º = Ecuador

Un satélite girando con una velocidad angular igual a la de la tierra (3.0746 km/seg), en una latitud cero (sobre el Ecuador), y a una distancia aproximada de 36,000 km respecto a la superficie terrestre (o a 42,162 km del centro de la tierra), se dice que es un satélite geoestacionario.

Existe una gran variedad de satélites artificiales con una gran variedad de aplicaciones, tales como, celestes (Colocados en otros cuerpos celestes como el Sol y entre otros planetas), científicas, militares y astronómicas y equipado según su contenido, con diferentes instrumentos y fuentes de energía (Una de ellas equipada con celdas solares).

Satélites Científicos; Recogen datos del campo magnético terrestre, auroras boreales y distintos tipos de radiación.

Satélites Astronómicos; Permiten escrutar el espacio sin el obstáculo que presenta la atmósfera terrestre, que absorbe gran parte de la luz y la radiación.

Satélites Meteorológicos; Recogen información sobre la atmósfera, los sistemas de nubes y el equilibrio térmico.

Satélites de Comunicaciones; Permiten la transmisión de llamadas telefónicas, imágenes y programas de televisión a cualquier parte del mundo, transmisión de datos, red Internet, etc.

Satélites de Navegación; Situados en órbitas fijas, emiten señales para ayudar a barcos y aviones a determinar su posición.

Satélites de Observación ó Espías; Fotografían instalaciones militares, nucleares, detectores de misiles y es utilizado básicamente para fines militares.

7 TIPOS DE ORBITAS

En el creciente avance Tecnológico de las Telecomunicaciones del Mundo y la demanda de mejores servicios de comunicación, también los satélites son construidos de acuerdo a las necesidades por lo que estos tienen características diferentes. Existen diferentes tipos, como son; Satélites Geoestacionarios (los que conocemos como GSO), De Órbita Baja (los que conocemos como LEO), De Órbita Media (los que conocemos como ICO), que se encuentran a diferentes distancias de la tierra, algunos en un punto de coordenadas fijo y otros en un movimiento de translación alrededor de la Tierra. Los satélites que se utilizan en la Red Edusat son Geoestacionarios

Figura 12

ORBITA BAJA

En esta órbita se encuentran los satélites conocidos como satélites de órbita baja (LEO), se encuentra aproximadamente a 1000 Km, de la Tierra y que regularmente es una constelación de satélite girando en movimiento de translación alrededor de la Tierra para tener una cobertura completa de la región, su utilidad es en la Radiocomunicación Digital, La Estrategia Militar, Aeronáutico y Marino, La Telefonía Celular y La Transmisión de Datos.

ORBITA MEDIA

En esta órbita se encuentran los satélites conocidos como satélites de órbita media (ICO), se encuentra aproximadamente entre 10,000 y los 20,000 Km, de la Tierra y que regularmente es una constelación de satélite girando en movimiento de translación alrededor de la Tierra para tener una cobertura completa de la región. Estos satélites giran en dos grupos iguales, en forma perpendicular cada grupo, su utilidad es en la Radiocomunicación Digital, La Estrategia Militar, Aeronáutico y Marino, La Telefonía Celular y La Transmisión de Datos.

ÓRBITA GEOESTACIONARIA.

En esta órbita se encuentran los satélites conocidos como satélites Geoestacionarios (GSO), se encuentra aproximadamente a 36,000 Km, de la Tierra, la que se conoce como arco satelital, estos satélites mantienen un punto de coordenadas fijo con respecto a la Tierra, esto permite cubrir una región.

Estos satélites giran junto con la Tierra, se encuentran sobre la línea imaginaria del Ecuador. Estos satélites pueden transmitir Datos, Voz, Radiocomunicación, Telefonía, Vídeo, TV.

8 SATÉLITES GEOESTACIONARIOS

Son todos los Satélites Artificiales que están situados en órbita a 35.812 Km (22.247 millas) aproximadamente, este es el lugar donde las fuerzas de gravedad y las espaciales están en equilibrio y giran sobre el Ecuador, además de mantener un punto de coordinadas fijo con relación a la tierra ya que el giro es sin perder este punto.

ARCO SATELITAL

El arco satelital es donde se encuentran ubicados todos los satélites geoestacionarios, estos están sobre la línea imaginaria del Ecuador a 36000 Km aproximadamente de la tierra.

9 TRANSPONDER

Es un dispositivo que forma parte del satélite, el cual cuenta con varios Transponders en su interior, estos son capaces de recibir el mensaje, lo desglosa, amplifica y lo transmite al receptor, el cuál hace una serie de ajustes con la polaridad, tiene la capacidad de transformar el mensaje de digital a analógico y de analógico a digital los satélites tienen 12 Transponders verticales y 12 horizontales.

Tiene como función principal la de amplificar la señal que recibe de la estación terrena, cambiar la frecuencia y retransmitirla nuevamente a una o varias estaciones terrenas, con una cobertura amplia. La función de un transponder es recoger la señal entrante de la antena receptora, esta señal es amplificada por un LNB (amplificador de bajo ruido), el que incrementa la señal sin admitir ruido. A la salida del LNA la señal es pasada a un convertidor de frecuencia que reduce la señal a su frecuencia descendente. La señal descendente pasa para su amplificación final a un amplificador de alta potencia (HPA) (usualmente de 5 a 15 watts), el que tiene un tubo de ondas progresivas (TWT) como amplificador de salida. Una vez concluido el proceso la señal es pasada a la antena descendente y se realiza el enlace descendente con la estación receptora.

Transponder tipo N: Transponder angosto con un ancho de banda de 36 MHz en banda C (6/4 GHz).

Transponder tipo W: Transponder ancho de banda de 72 MHz en banda C (6/4 GHz).

Transponder tipo Ku: Transponder de 54 o 108 MHz ancho de banda en banda Ku (14/12 GHz).

Figura 13

Diagrama de un Transponder en banda C

10 TÉCNICAS DE ACCESO A SATÉLITE

Se conocen muchos algoritmos para repartir un canal de acceso múltiple, por lo que implica tener diferentes técnicas de acceso que se pueden encontrar en el ancho de banda. Una de estas técnicas es el TDM (Multiplexación por división de tiempo) y la otra es el FDM (Multiplexación por división de frecuencia).

Por ejemplo, consideremos la teoría de la fiesta de cóctel de acceso a un canal, en ella se encuentran muchas parejas conversando. TDM es cuando toda la gente está en el centro del cuarto, pero se turnan para hablar, primero uno, y luego el otro. FDM es cuando la gente se junta en grupos ampliamente dispersos, llevando cada grupo su propia conversación al mismo tiempo que los demás, pero indefinidamente.

CDMA (Acceso Múltiple por División de Código), es completamente diferente de las demás técnicas de reparto que hemos estudiado hasta ahora. Algunas de éstas se han basado en la división del canal en bandas de frecuencia y la asignación de ella estáticamente (FDM) o por demanda (Multiplexión por división en longitud de onda), con el propietario usando indefinidamente la banda. Otras reparten el canal en ráfagas, dando estáticamente a las estaciones el canal completo (TDM con ranuras de tiempo fijas) ó dinámicamente. El CDMA permite que cada estación transmita en el espectro completo de frecuencia todo el tiempo. Las transmisiones múltiples simultáneas se separan usando la teoría de codificación. El CDMA también relaja el supuesto de que los marcos en colisión se alteran completamente. En cambio, supone que las señales múltiples se suman linealmente. El CDMA es cuando todos están en el centro del salón hablando al mismo tiempo, pero hablando cada pareja un lenguaje distinto. La pareja de franco parlantes sólo se encuentra en el francés, rechazando todo lo demás como ruido. Por tanto, la clave de CDMA es ser capaz de extraer la señal deseada mientras se rechaza todo lo demás como ruido aleatorio.

Las siglas TDMA significan acceso múltiple por división de tiempo, donde una pequeña cantidad de conversación de voz, perteneciente a un usuario es transmitida luego una segunda porción de información perteneciente a otro usuario así hasta completar otro ciclo terminando cuando todos los usuarios hayan terminado de transmitir.

Considerando un sistema TDMA con 5 usuarios para cada banda de frecuencia alternando 10 milisegundos, por lo que cada usuario tendrá un rango de 2 milisegundos.

Además de aumentar la eficiencia de la transmisión TDMA ofrece una adaptación fácil a la transmisión de datos así como la comunicación de voz. TDMA tiene la capacidad de llevar índices de datos de 64 Kbps a 120 Mbps (extendible en múltiplos de 64 Kbps).

Una de las desventajas de TDMA es que cada usuario tiene una ranura de tiempo predefinida y también TDMA esta sujeto a distorsión multidireccional.

Una forma de conseguir minimizar está de desventaja es el de poner un limite de tiempo en el sistema.

11 ESTRUCTURA BÁSICA DE UNA ESTACIÓN TERRENA.

El término de estaciones terrenas se emplea de formas indistinta para indicar todo el equipo terminal que se comunica con el satélite desde tierra sin importar si esta fija o móvil y se clasifican en diferentes categorías dependiendo del servicio:

Las estaciones fijas son las que se encuentran situadas en un determinado punto y no se mueven, el único cambio que se permite es el de apuntar hacia otro satélite si la antena lo permite.

Las estaciones terrenas móviles son las que tienen capacidad de enlazarse con el satélite cuando están fijas o en movimiento, a este tipo de estaciones pertenecen las que operan en banda L y que se instalan en vehículos, aviones y barcos.

Las estaciones terrenas móviles transportables tiene la característica de que pueden transportarse en medios terrestres, aéreos o marítimos hasta el lugar que se requiere el enlace al satélite que generalmente son de dimensiones pequeñas y que no trabajan en movimiento.

En cuestión de las estaciones móviles transportables se contó con tres generaciones, en la primera se tenía por separado la antena, el equipo de transmisión y la planta generadora de energía eléctrica, en la segunda se incluye equipo de transmisión con la planta generadora y con la antena aparte, para la tercera el equipo se monta sobre una unidad.

Figura 13

12 CONFIGURACIÓN DE UN SISTEMA DE COMUNICACIONES VÍA SATÉLITE.

Por lo general en una estación terrena la misma antena se utiliza tanto para transmitir como para recibir si es que la aplicación así lo requiere por lo que los bloques de transmisión y recepción están conectados por medio de un dispositivo llamado duplexor. A continuación se muestra el diagrama a bloques de una estación terrena en el cual no se emplea la redundancia de ningún modulo, pero en la practica es necesaria por cuestiones de continuidad en una transmisión.

Diagrama a bloques de una estación terrena. Figura 14

13 SISTEMA DE TRANSMISIÓN

Cuando se transmite una señal de información ya sea analógica o digital vía satélite típicamente se inicia con un proceso de modulación en los módems posteriormente se aumenta la frecuencia de la señal modulada a través de los conversores de subida, posteriormente cual aumente la potencia de la señal por medio de los HPA’S, ya modulada la señal, aumentada en potencia y frecuencia es radiada en dirección del satélite por la entena transmisora. El equipo para la transmisión es:

Módem o Encoder.

Convertidor de subida.

Amplificador de alta potencia (HPA).

Antena transmisora.

Módems:

Los módems generan la señal modulada a transmitirse, conjuntado las características deseadas de la señal moduladora y la portadora, la primera es en formato digital proveniente de las fuentes de información y la segunda señal, la portadora, generalmente es una señal senoidal generada internamente en el módem. La señal portadora es modulada digitalmente en fase (PSK) empleando en la mayora de los casos la QPSK. Por lo que son necesarias las siguientes características.

Pasos de sintonía: Este parámetro se refiere a la frecuencia mínima que es capaz nuestro módem de registrar o sintonizar, generalmente son de 125 Hz.

Velocidad de información: Es la cantidad de bits de información que se acepta en el dispositivo en que se recibe la información entre el tiempo total que se requiere para la aceptación de los bits.

FEC (Forward Error Correction): En este tipo de corrección de error se agrega a la señal de información como una serie de bits que corresponden a un código, se asignan Fec’s de ¾, lo que quiere decir que por cada 4 bits que se envían 3 bits son de información y un bit es de detección de error.

Roll Off: Es una característica de la calidad de los filtros pasa-bajos de los módems para una selección adecuada de la frecuencia de corte.

BER (Bit Error Rate): La tasa de bits erróneos se define como la relación entre la cantidad de bits que se reciben incorrectamente contra los bits que se transmiten.

14 CONVERTIDOR DE SUBIDA

El convertidor de subida es el equipo que eleva la frecuencia de la señal modulada desde el rango de frecuencia intermedia hasta el de radio frecuencia ya sea banda KU o C.

AMPLIFICADORES DE ALTA POTENCIA (HPA):

El amplificador le proporciona a la señal modulada la potencia necesaria para llegar al satélite con el nivel adecuado para lograr el enlace, los circuitos amplificadores de alta potencia son usados de acuerdo ala potencia de transmisión y al ancho de banda que manejan. Existen tres tipos de principales de amplificadores de alta potencia que son el TWT (Traveling Wave Tube), el SSPA (Solid State Power Amplifier) y la válvula KLISTRON.

PARÁMETRO |

KLISTRON |

TWT’S |

FET’S |

Circuito de amplificación |

Klystron |

TWT |

GaAs FET |

Potencia de salida |

Alta |

Alta |

Baja |

Tamaño |

Grande |

Mediano |

Pequeño |

Peso |

Grande |

Mediano |

Pequeño |

Ancho de banda |

Decenas de MHz |

Cientos de MHz |

Cientos de MHz |

Enfriamiento |

Aire para Kw |

Aire para Kw |

Normal |

Voltaje de la fuente de poder |

Mediano |

Alto |

Bajo |

Tabla 4

Gracias a los TWT se tiene un ancho de banda de amplificación grande además de que es útil para la transmisión de varias portadoras. Por otra parte el Klystron tiene un ancho de banda pequeño pero su frecuencia es ajustable a cualquier frecuencia reservada para transmisión.

15 ANTENAS

Una antena parabólica tiene la propiedad de reflejar las señales que llegan a ella y concentrarlas como si fuera un lente en un punto en común llamado foco, así mismo si las señales provienen del foco este las refleja y las concentra en un haz muy angosto de radiación. Este foco coincide con el foco geométrico del paraboloide, el tipo de alimentador define la ganancia final de la antena y las características de los lóbulos.

TECNOLOGÍA DE LAS ANTENAS.

Las antenas deben de cumplir con ciertos requisitos para recibir las señales débiles que llegan procedentes del satélite las cuales son;

TIPOS DE ANTENA.

Hay varios tipos de alimentación de una antena parabólica pero los más utilizados son frontal, Cassegrain y offset.

Figura 15

Las antenas de alimentación frontal tienen una estructura simple y de bajo costo se emplea principalmente para la recepción, sin embargo sus características de ganancia, eficiencia y directividad no son muy buenas. La antena cassegrain es mucho más eficiente ya que la ganancia es mayor se utiliza en transmisión y recepción de televisión, señales de telefonía y datos, su configuración involucra a un segundo reflector o sub reflector, así como el alimentador. La antena offset emplea una sección del plato parabólico y la apertura del alimentador se gira para qué apunte hacia ella, es decir que los ejes del reflector no coinciden con el paraboloide, con estas características la eficiencia, directividad y ganancia aumentan.

Las características más importantes en las antenas transmisoras son:

Ganancia de antena.

Patrón de radiación.

PIRE (Potencia Isotropita Radiada Efectiva)

Antes de pasar a la descripción del proceso de apuntamiento de las antenas parabólicas utilizadas en la recepción de señales vía satélite, conviene conocer las técnicas básicas utilizadas.

La orientación de la antena de una estación terrena hacia un satélite geoestacionario se realiza ajustando dos ángulos, en elevación y azimut; los valores de estos ángulos dependen de la posición geográfica de la estación –en latitud y longitud- y de la ubicación en longitud del satélite. Tomando como referencia al eje de simetría del plato parabólico, que coincide con su eje de máxima radiación, el ángulo de elevación es aquel formado entre el piso y dicho eje de simetría dirigido hacia el satélite como se muestra en la figura siguiente.

Figura 16

DEFINICIÓN DEL ÁNGULO DE ELEVACIÓN DE LA ANTENA DE UNA ESTACIÓN TERRENA.

Por su parte, el ángulo de azimut es la cantidad en grados que hay que girar la antena en el sentido de las manecillas del reloj –con relación al norte geográfico de la tierra- para que ese mismo eje de simetría –prolongado imaginariamente- pase por la posición en longitud del satélite.

DEFINICIÓN DEL ÁNGULO DE AZIMUTH DE UNA ESTACIÓN TERRENA.

Dependiendo de la localización de la estación terrena con respecto a la posición del satélite, el ángulo de azimut está dado por:

CASO 1 ESTACIÓN EN EL HEMISFERIO NORTE

Satélite al Oeste de la Estación

Az = 180° + A’

CASO 2 ESTACIÓN EN EL HEMISFERIO SUR

Satélite al Este de la Estación

Az = A’

Para calcular el ángulo de azimut basándose en lo mencionado anteriormente tenemos:

A’ = Tan-1 { Tan (LONG SAT – LONG E/T) }

{SEN (LAT E/T) }

Para calcular la elevación, primero tenemos:

A = Tan-1 { HCS – R cos d }

{ R sen d }

Donde:

HCS = Distancia promedio del centro de la Tierra al Satélite = 42164.2 km

R = Radio Promedio de la Tierra = 6378.155 km

Cos d = { Cos (Latitud E/T) (Cos (Long SAT – Long E/T)) }

Y para el cálculo de elevación tenemos:

E = A - d

Ejemplo:

Calcular las coordenadas de azimut y elevación a las que se tiene que poner una antena en Panamá para orientarse al Satélite Satmex V, teniendo en cuenta que las coordenadas de la estación transmisora en Panamá son las siguientes:

Latitud de la Estación Terrena = 8.58° N

Longitud de la Estación Terrena = 79.32° W

Longitud del Satélite = 116.8° W

Se calcula primero el ángulo el Cos d

Cos d = { Cos (Latitud E/T) (Cos (Long SAT – Long E/T)) }

Sustituyendo valores tenemos:

Cos d = Cos (8.58) Cos (116.8 – 79.32)

= 0.9888 (0.7935)

= 0.7840

d = Cos-1 0.7840

d = 38.372°

Por lo tanto:

A = Tan-1 { 42164.2 – (6378.155)(0.7840) }

{ 6378.155 (Sen 38.372) }

A = Tan-1 { 37163.726 }

{ 3959.33 }

A = 83.919°

Sustituyendo:

E = A - d

E = 83.919 – 38.372

E = 45.547°

Y el azimut, sabiendo que el satélite está al Oeste de la estación:

Az = 180 + A

Az = 180 + { Tan-1 { Tan (116.8 – 79.32) } }

{ Sen (8.58) }

Az = 180 + { Tan-1 { Tan 37.48 } }

{ 0.149 }

Az = 180 + 79.00

= 259.0°

Se a descrito el método matemático para hacer el apuntamiento de antena, pero a continuación se hace mención de cómo hacerlo en forma gráfica.

APUNTAMIENTO EN FORMA PRÁCTICA

Después de que ya se tiene los ángulos de azimut y elevación obtenidos para forma matemática o gráfica, pues se procede a realizar el apuntamiento en forma práctica.

En la practica, los métodos más empleados para orientar una antena parabólica en azimut son el solar, el de estrella polar, y el de brújula, siendo este ultimo el más popular y el que se sugiere utilizar, para esto es necesario que la antena esté emplazada en un lugar donde no exista ningún obstáculo para recibir la señal del satélite.

Tras ser montada la antena, la cuál para facilitar su orientación deberá ser montada siempre en dirección hacia el sur, se puede apuntar de forma aproximada con la ayuda de la brújula, sin embargo la falta de precisión de la medida dada por la brújula hace que el punto calculado no sea más que una aproximación. Así mismo, al hacer la medida del azimut utilizando la brújula, debe situarse lejos de cualquier objeto metálico, por ejemplo el mástil de la antena, que pueda perturbar la indicación de la aguja.

Dada la mayor precisión del ángulo de elevación, lo más conveniente es ajustar primero éste ángulo. Con la ayuda de un receptor de TV (para el caso de servicios de Televisión), o de un analizador de espectros, encontramos el máximo nivel de señal para éste punto, y posteriormente se gira la antena ligeramente hacia el Este según el azimut calculado, hasta observar que se recibe un máximo de señal.

Una vez localizado el máximo, se fijará la parábola y se hará un nuevo ajuste del ángulo de elevación, hasta conseguir un nuevo máximo en el nivel de recepción. Finalmente, los procesos de ajuste de azimut y elevación se pueden repetir a fin de optimizar el apuntamiento.

INSTRUMENTOS UTILIZADOS EN LA ORIENTACIÓN

Después de que ya se han determinado los ángulos para orientar la antena, es necesario conocer un poco de los equipos que nos ayudarán para realizar el apuntamiento en forma práctica, como son el inclinómetro, la brújula, el analizador de espectros y el equipo de recepción de satélite, y a continuación hacemos una breve descripción de algunos de ellos y como nos ayudan a realizar el apuntamiento.

LA BRUJULA

Para medir el ángulo de azimut de una antena, el instrumento que debe utilizarse es la brújula, la cuál se puede observar en la figura siguiente.

La brújula es un dispositivo magnético, que siempre nos indica la dirección de las líneas de fuerza del campo magnético terrestre, o sea de Norte a Sur. Ahora, teniendo en cuenta, por una parte, la ley de las atracciones y las repulsiones magnéticas y, por otro lado, que el polo norte de una brújula se dirige hacia el polo norte geográfico de la Tierra, se deduce que el polo magnético de la Tierra que se encuentra en el Norte de la misma es el polo sur magnético, ya que atrae al polo norte de la brújula. Recíprocamente, el polo magnético que se encuentra en el sur geográfico es el polo norte magnético, ya que atrae el polo sur de la brújula.

Sin embargo las brújulas no apuntan directamente al Norte, sino que en realidad la dirección de la brújula forma un cierto ángulo con el meridiano terrestre. Al ángulo que forma la brújula con el meridiano terrestre se le llama declinación magnética en el lugar considerado. Por lo que al hacer el apuntamiento de la antena es necesario considerar éste valor.

Existen ciertos lugares donde la declinación magnética es igual a cero; por ejemplo, en algunas zonas del estado de Florida, del caribe y de América del sur. En estos lugares el azimut de una antena queda perfectamente definido por la orientación de la brújula, sin necesidad de efectuar ningún ajuste. Por otra parte, la declinación magnética puede tomar valores de 100° o más, como ocurre en el archipiélago de Parry, Canadá. En el continente americano, entre las latitudes 60° S y 55° N, esta declinación varia entre 0° y 35° E u O, y en el caso particular de la Republica Mexicana, el intervalo de variación esta entre 5° E y 14° E.

Para orientar antena parabólica en azimut es preciso restar o sumar la declinación magnética valor leído en la brújula, dependiendo de sí la inclinación es hacia el oeste o el este, para localizar el verdadero azimut geográfico. Existen datos publicados de la declinación magnética por zonas geográficas en las llamadas “cartas de líneas isogonicas” y debido a que los polos magnéticos norte y sur varían ligeramente de posición con el tiempo, existen organismos nacionales e internacionales que realizan nuevas mediciones cada tres o cinco años, para actualizar dichas cartas.

En la siguiente tabla se muestran los valores de declinaciones magnéticas de algunos lugares de la República Mexicana.

Ciudad de México |

6.8 |

Guadalajara |

8.1 |

Monterrey |

7.7 |

Ciudad Juárez |

10.9 |

Puebla |

6.6 |

Tijuana |

13.7 |

Tampico |

6.8 |

Torreón |

8.8 |

Mexicali |

13.5 |

Chihuahua |

10.1 |

Acapulco |

6.6 |

San Luis Potosí |

7.5 |

Veracruz |

5.9 |

Hermosillo |

11.6 |

Mérida |

3.2 |

Tabla 5

EL INCLINÓMETRO

Para el caso de encontrar el ángulo de elevación de una antena, el instrumento utilizado es un inclinómetro, y una de las formas de realizar la medida consiste en colocar el listón sobre el plato y el inclinómetro encima. Dado que el ángulo medido y la elevación difieren en 90°, el ángulo medido deberá ser:

Figura 17

Ángulo medido = 90° - ángulo de elevación

Ya que se ha orientado una antena, colocándola en los ángulos de azimut y elevación con la ayuda de los instrumentos ya mencionados, como sabemos si ya podemos captar señal, y además saber si ésta es óptima, por lo que es necesario conectar un receptor a la salida de la antena, por lo que se puede ver que el receptor es igual de importante que el subsistema de antena, y por esto vamos a hacer una descripción mas detallada de la parte receptora.

17 EL RECEPTOR

La parte de recepción como se mencionó anteriormente, es la que nos va a indicar que tan bueno ha sido nuestro apuntamiento de antena con el satélite, por lo que este equipo toma una gran importancia en este proceso. Podemos hablar en el caso de que el lado receptor sea una Estación Terrena o un caso más sencillo, que se trate de un receptor de TV. Los equipos básicos necesarios para recibir una señal de satélite son: Un LNB, y el receptor de satélite en sí.

El LNB es un equipo que en un solo bloque realiza las funciones de un LNA y un Down Converter que se utilizan en una Estación Terrena, ya que la señal que llega a la antena, al pasar por el LNB, la amplifica manteniendo fija la relación señal a ruido, y además la convierte a una frecuencia de FI que está en el rango de 950 a 1450 MHz.

Y el proceso de demodulación y de decodificación de la señal que se hacían en dos bloques distintos en la Estación Terrena, se lleva acabo enteramente en el receptor de TV vía satélite.

En la siguiente figura se muestra la configuración básica de un sistema de recepción.

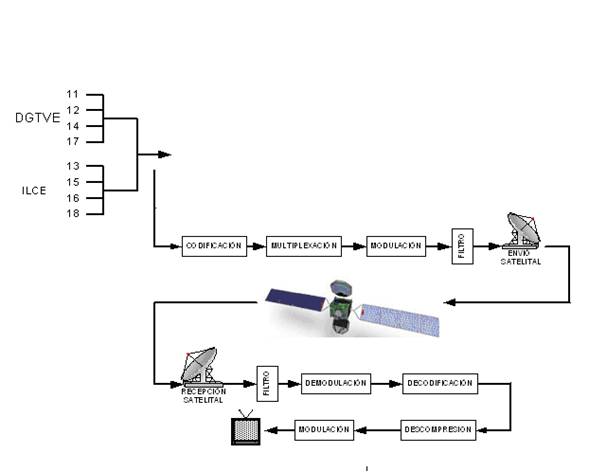

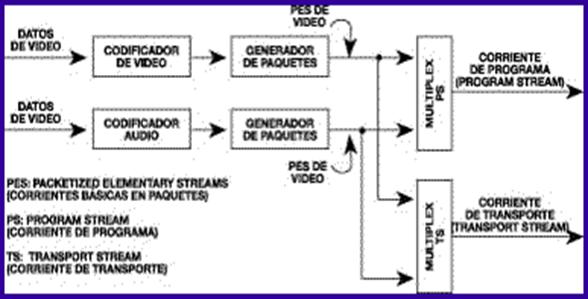

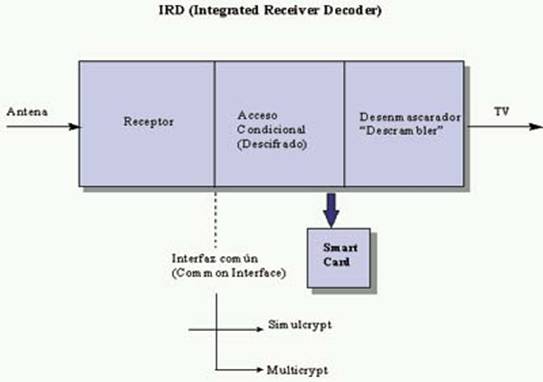

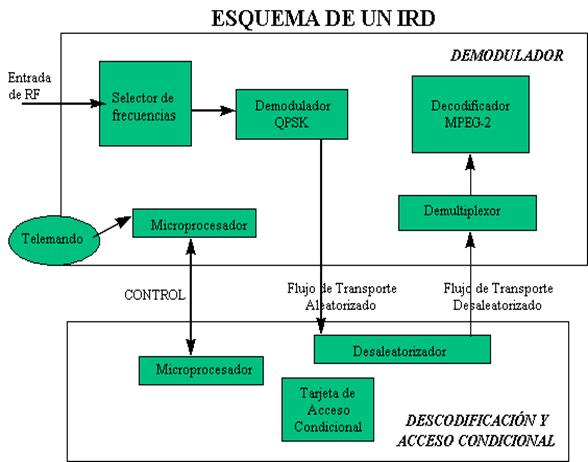

18 Procesamiento de la señal de La Red Edusat

Para poder transmitir la señal de La Red Edusat, ésta debe pasar por una serie de procesos en el transmisor que permiten ordenar la información en una trama de bits. Este proceso se realiza empleando la compresión digital, multiplexión, codificación, decodificación, encriptación, modulación y desmodulación mediante el uso de la tecnología Digicipher I y II. El siguiente diagrama muestra el proceso que transforma a la señal de La Red Edusat, a una forma adecuada para transmitirse vía satélite, la primera etapa se realiza en el telepuerto de la DGTVE, y la segunda etapa la realiza el decodificador.

DIAGRAMA A BLOQUES DEL PROCESAMIENTO DE LA SEÑAL

Equipo de recepción de La Red Edusat. Figura 18

El equipo está conformado por los siguientes elementos:

Observarse en el televisor. Permite además seleccionar los canales de la

Red Edusat.

La configuración básica que se tiene en un control maestro para la conexión de video se muestra en la siguiente figura:

Figura 19

En el diagrama anterior se muestra solamente la configuración en video, la configuración en audio es la misma, solo que se maneja por dos canales (izquierdo y derecho).

19 VIDEO ANÁLOGO

En un sistema análogo, la información se transmite mediante alguna variación infinita de un parámetro continuo como puede ser la tensión en un hilo o la intensidad de flujo de una cinta. En un equipo de grabación, la distancia a lo largo del soporte físico es un elemento análogo continuo más del tiempo. No importa en que punto se examine una grabación a lo largo de toda su extensión: se encontrará un valor para la señal grabada. Dicho valor puede variar con una resolución infinita dentro de los límites físicos del sistema.

Figura 20

Variación infinita de un parámetro continúo en función del tiempo

Dichas características suponen la debilidad principal de las señales análogas. Dentro del ancho de banda permisible, cualquier forma de onda es válida. Si la velocidad del soporte no es constante, una forma de onda que sea válida pasará a ser otra forma de onda también válida; no es posible detectar un error de base de tiempos en un sistema análogo. Además, un error de tensión tan sólo hace variar un valor de tensión válido en otro; el ruido no puede detectarse en un sistema análogo.

Se puede tener la sospecha de que existe ruido, pero no se sabe qué proporción de la señal recibida corresponde al ruido y cual es la señal original. Si la función de transferencia de un sistema no es lineal, se producirán distorsiones, pero las formas de onda distorsionadas aún serán válidas; un sistema análogo es incapaz de detectar distorsiones.

Es característico de los sistemas análogos el hecho de que las degradaciones no puedan ser separadas de la señal original, por lo que nada pueda hacerse al respecto. Al final de un sistema determinado la señal estará formada por la suma de todas las degradaciones introducidas en cada etapa por las que haya pasado. Esto limita el número de etapas por las que una señal puede pasar sin que quede inutilizable.

El comité nacional de estándares de televisión estableció la norma NTSC (National Television Standards Committee), como norma establece un sistema de 525 filas entrelazadas a 30 imágenes por segundo (es decir, a una frecuencia de 60 Hz para el vertical y 15750hz para la frecuencia horizontal). Como en el caso de la norma PAL/SECAM, el 8% de las filas se utiliza para sincronizar el receptor. De esta manera, dado que la norma NTSC muestra un formato de imagen de 4:3, la resolución que se muestra en realidad es de 640 x 480. Se utiliza primordialmente en los Estados Unidos, Canadá, Groenlandia, México, Cuba, Panamá, Japón, las Philipinas, Puerto Rico, y parte de Sur-América. La imagen de televisión para dar una sensación de movimiento se tienen que trasmitir 30 cuadros o imágenes los cuales se dividen en dos campos y se transmiten entrelazados dando como resultado su frecuencia vertical de 60, al NTSC se le conoce como un sistema de 525 líneas y 60 campos. El sistema NTSC fundamentó su ciclo temporal en la frecuencia de oscilación eléctrica de 60 Hz. Hay otros países con frecuencia de 50Hz, y se hizo lógico desarrollar un sistema de televisión sobre la base de 50 ciclos.

Mas de la mitad de los países del mundo se adhieren a uno de los dos sistemas de 625 líneas, y 25 cuadros: SECAM (Systèm Électronique pour Couleur avec Mémoire) o PAL (Phase Alternating Line).

SECAM se utiliza básicamente en Francia y los países que antes pertenecían a la antigua Unión Soviética. PAL se utiliza en la mayor parte de Europa Occidental exceptuando Francia y en Argentina.

Figura 21

Las 100 líneas extra en los sistemas PAL y SECAM permiten mayor detalle y claridad en la imagen de video, pero los 50 campos por segundo, comparados con los 60 del sistema NTSC producen cierto "parpadeo" a veces aparente. Aún así como 25 cuadros por segundo están muy cerca del estándar internacional para cine de 24 cuadros por segundo, el cine se transfiere más fácilmente a PAL Y SECAM. En NTSC una película de 24 cuadros por segundo debe ser convertida a 30 cuadros. Esto es efectuando un barrido por duplicado (escaneo) algunos fotogramas de la película a intervalos cíclicos.

Esto solía ser un problema pero con la tecnología digital actual es un proceso simple y limpio asumiendo que se tenga acceso a los equipos adecuados. Además hoy existen televisores y videograbadoras multi-estándar que permiten cambiar con un switch entre uno y otro sistema. Se debe recordar que todas las normas vigentes de televisión en la actualidad, NTSC (National Television Systems Comitee), PAL (Phase Alternation Line) y SECAM (Systeme Electronique Color Avec Memoire) se derivan, directa o indirectamente, de los estándares en blanco y negro definidos en los años 40 y 50. Estas primeras emisiones utilizaban un barrido progresivo (todas las líneas de la imagen se barren consecutivamente, como se puede ver en la Figura).

Figura 23

Representación simplificada del barrido progresivo

Por razones de orden práctico (radiaciones debidas a fugas magnéticas de los transformadores de alimentación, filtrados imperfectos), fue indispensable utilizar una frecuencia de imagen que estuviera relacionada con la frecuencia de la red (60 Hz en EE.UU., 50 Hz en Europa) para minimizar el efecto visual de estas imperfecciones; la frecuencia de exploración fue, por tanto, de 30 imágenes/s en EE.UU. y de 25 imágenes/s en Europa. Estas primeras imágenes presentaban un parpadeo bastante molesto (también llamado flicker de campo). Tiempo después la captación de la imagen se hizo electrónica, haciendo que las definiciones alcanzaran un mayor número de líneas, esto gracias al barrido entrelazado.

Barrido entrelazado.

Consiste en la transmisión de un primer campo compuesto por las líneas impares de la imagen y a continuación un segundo campo formado por las líneas pares, como se ve en la figura 23. Esta forma de barrer la imagen, permite duplicar la frecuencia de refresco de la pantalla (50 o 60 Hz, en lugar de los 25 o 30 Hz) sin aumentar el ancho de banda para un número de líneas dado. Como se ve en la figura 24, el barrido entrelazado se obtiene utilizando un número impar de líneas, por ejemplo 525 o 625 líneas que constituyen un cuadro, de manera que el primer campo comience en una línea completa, terminando en la mitad de otra línea, y el segundo campo comience en la mitad de una línea y finalice con una línea completa. En los países donde la frecuencia de la red es de 60 Hz, la velocidad de cuadro es de 30 por segundo y, por consiguiente, la frecuencia de campo es de 60 Hz.

Figura 23

Cuadro completo

Barrido entrelazado 2:1

Debe haber un número impar de líneas en cada cuadro Figura 24

Frecuencias de exploración horizontal y vertical.

La velocidad de campo de 60 Hz es la frecuencia de exploración vertical. Este es el ritmo con que el haz electrónico completa su ciclo de movimiento vertical, desde la parte superior hasta la parte inferior de la pantalla para volver nuevamente a la parte superior. El número de líneas de exploración horizontal de un campo es la mitad del total de las 525 líneas de un cuadro completo (en el sistema NTSC), ya que un campo contiene la mitad de las líneas. Esto da por resultado 262.5 líneas horizontales para cada campo. Como el tiempo que corresponde a un campo es 1/60s y cada campo contiene 262.5 líneas, el número de líneas por segundo es:

262.5 x 60 = 15750 líneas/s

Esta frecuencia de 15750 Hz es la velocidad con que el haz electrónico completa su ciclo de movimiento horizontal de izquierda a derecha y regresa nuevamente a la izquierda. El tiempo durante el cual se realiza la exploración de una línea horizontal es:

1/15750 » 63.5 ms

Existen dos procesos simultáneos en la exploración, uno mueve el haz en sentido horizontal y el otro en sentido vertical; ambas son exploraciones lineales y se efectúa a una velocidad constante.

Para que estas exploraciones se lleven a cabo es necesario que el haz de exploración se le aplique una sincronización o pulsos que manejen la velocidad y la posición en el haz horizontal y vertical. Para eliminar la distorsión de la imagen debido a la velocidad inicial y a la velocidad final de una línea, al igual que la aceleración y desaceleración del retorno de haz se introduce a cada una de las líneas pulsos de borrado o blanking.

Este pulso trabaja moviéndose el haz de electrones horizontalmente y cada una de sus partes se mide en microsegundos, cuando el haz se desplaza a lo largo de la pantalla debe hacerse con una velocidad constante, no así al inicio y al termino del trazo donde la velocidad es de cero debido a que el haz inicia con un aumento de velocidad de cero a la normal y termina de la velocidad normal a cero.

Esto ocasiona que los extremos de la pantalla los elementos de imagen estén más juntos que en el resto de la pantalla, para eliminar esta distorsión se suprime la información de imagen de estos lados mediante el blancking horizontal.

Después de esto el haz describe la información de la primera línea durante 63.3 ms hasta llegar al siguiente lado de la pantalla donde el front porch cortara la señal del video activo por 1.5 ms. Hasta detener el haz y empezar el regreso hacia ala parte izquierda de la pantalla.

Este proceso la realiza la sincronía horizontal y el tiempo que dura el retroceso hasta llagar del otro lado es de 4.7.

Al llegar al lado izquierdo se detiene el haz y empieza a describir una nueva línea, aquí se inicia nueva mente el ciclo con la parte del pulso llamada breezeway la cual se indica que se describe una línea con una referencia de color llamada burts y así hasta completar las 525 líneas.

BLANCKING VERTICAL

Este pulso trabaja moviendo el haz de electrones desde la parte inferior hasta la superior de la pantalla este movimiento lo realiza e en el tiempo de 21 líneas.

Así como el blancking horizontal el vertical suprime la información de la imagen en la parte inferior y en la parte superior debido a las variaciones de la velocidad del haz al descender y ascender por lo que también es necesario borrarlo.

El haz empieza a moverse horizontalmente desde la izquierda de la pantalla y no describe la información o no permite que se empiece a describir la primera de las 525 líneas horizontales que forman a un cuadro de imagen hasta después de que transcurren 4.7 ms. El barrido vertical permite que el haz cubra la pantalla con las 525 líneas, el tiempo de este barrido son los que determinan la relación de aspecto de las pantallas también la relación de estas frecuencias determina el número de líneas horizontales que habrá en cada cuadro de imagen.

VIT’s: Vertical interval test

VIR’s: vertical interval reference.

VITC: vertical interval time code.

Figura 26

22 Las señales de color

El sistema para la televisión en color es el mismo que para la televisión monocromática excepto que también se utiliza la información de color. Esto se realiza considerando la información de imágenes en términos de rojo, verde y azul. Cuando es explorada la imagen en la cámara, se producen señales de video separadas para la información de rojo, verde y azul de la imagen.

Sin embargo, para el canal estándar de 6 MHz de televisión, las señales de video de rojo, verde y azul son combinadas de modo que se forman dos señales equivalentes, una correspondiente al brillo y otra para el color. Específicamente las dos señales transmitidas son las siguientes:

Señal de luminancia.

Contiene solo variaciones de brillo de la información de la imagen, incluyendo los detalles finos, lo mismo que en una señal monocromática. La señal de luminancia se utiliza para reproducir la imagen en blanco y negro, o monocroma. La señal de luminancia o Y se forma combinando 30% de la señal de video roja (R), 59% de la señal de video verde (G) y 11% de la señal de video azul (B), y su expresión es:

Y = 0.30R + 0.59G + 0.11B

Los porcentajes que se muestran en la ecuación corresponden a la brillantez relativa de los tres colores primarios (ver Anexo 1). En consecuencia, una escena reproducida en blanco y negro por la señal Y tiene exactamente la misma brillantez que la imagen original. La Figura 27 muestra como el voltaje de la señal Y se compone de varios valores de R, G y B. La señal Y tiene una máxima amplitud relativa de unidad, la cual es 100% blanca. Para los máximos valores de R, G y B (1V cada uno), el valor de brillantez se determina de la siguiente manera:

Y = 0.30(1) + 0.59(1) + 0.11(1) = 1 lumen

Los valores de voltaje para Y que se ilustran en la Figura son los valores de luminancia relativos que corresponden a cada color.

Obtención de la señal Y

Y = 0.30R + 0.59G + 0.11B

Figura 28

Valores de luminancia relativa

Señal de croma: La señal de croma es una combinación de las señales de color I y Q. La señal I o señal de color en fase se genera combinando el 60% de la señal de video en rojo (R), 28% de la señal de video en verde (G) invertida y 32% de la señal de video en azul (B) invertida, y se expresa como:

I = 0.60 R - 0.28 G - 0.32B

La señal Q o señal de color en cuadratura se genera combinando el 21% de la señal de video en rojo (R), 52% de la señal de video en verde (G) invertido y 31% de la señal de video en azul (B), y su expresióoacute;n es:

Q = 0.21R - 0.52G + 0.31B

Las señales I y Q se combinan para producir la señal C y debido a que las señales I y Q están en cuadratura, la señal C o croma es la suma vectorial de estas, y su expresión es:

Las amplitudes de las señales I y Q son, en cambio, proporcionales a las señales de video R, G y B. en la siguiente figura se muestra la rueda de colores para la radiodifusión de televisión. Las señales R, G y B se utilizan en la mayor parte de los receptores de televisión a color para demodular las señales de video R, G y B. En el receptor, la señal C reproduce colores en proporción a las amplitudes de las señales I y Q. El matiz (o tono del color) se determina por la fase de la señal C y la profundidad o saturación es proporcional a la magnitud de la señal C. La parte exterior del círculo corresponde al valor relativo de 1.

Representación de los colores en NTSC Figura 29

Así se consigue que los sistemas de color y monocromáticos sean completamente compatibles.

23 VIDEO DIGITAL

La digitalización de una señal de video tiene lugar en tres pasos:

Muestreo. Sea una señal análoga e (t) como la representada en el Figura 33. Se toman muestras breves de e (t) cada 15' a partir de t=0. En 360' se habrán explorado 24 muestras. El resultado será una serie de impulsos cortos cuyas amplitudes siguen a la señal análoga. A este tren de impulsos modulados en amplitud por la señal análoga se le denomina señal PAM (Pulse Amplitude Modulation o Modulación por Amplitud de Pulsos).Este muestreo puede representarse por la multiplicación de la señal análoga e (t) por un tren de impulsos (t), dando por resultado la señal de la parte inferior de la figura

Muestreo de una señal análoga e(t) por un tren de impulsos u(t)

Ahora bien, una señal de video está compuesta por un gran número de frecuencias formando un espectro continuo que va desde 0 a unos 5 MHz como se representa en la figura 31:

Figura 31

Banda base de la señal de video

Al muestrear esta señal, cada frecuencia de video aparecerá en las bandas laterales superiores e inferiores de cada armónico de la frecuencia de muestreo, incluyendo naturalmente la banda base, esto es, el armónico cero.

El espectro de la señal muestreada se presentará por tanto, como se ve en la siguiente figura. De esta misma figura se deduce una condición elemental que debe cumplirse: que fo>2fs para que la banda lateral inferior de la frecuencia de muestreo y la banda base no se superpongan.

Figura 32

Cuando la frecuencia de muestreo es fo<2fs

Otro motivo de "aliasing" se produce cuando el filtro no está bien calculado y permite el paso de frecuencias de la banda lateral inferior, aunque no estén solapadas con la banda base.

Cuando la frecuencia de corte del filtro PB es superior a fo-fs Figura 33

Cuantificación. Así se denomina al proceso mediante el cual se atribuye a cada muestra un valor de amplitud dentro de un margen de niveles previamente fijado. Este valor se representa por un número que será convertido a un código de ceros y unos en el proceso de codificación.

Por razones de facilidad en los cálculos, el número de niveles se hace coincidir con una potencia de dos y los impulsos de la señal PAM se redondean al valor superior o inferior según sobrepasen o no la mitad del ancho del nivel en que se encuentran.

El error que se produjo con estas aproximaciones equivale a sumar una señal errónea a los valores exactos de las muestras, como se ve en la siguiente figura

Error de cuantificación Figura 34

Esta señal errónea aparecerá en el proceso de recuperación después de la decodificación digital-análoga, en forma de ruido visible. Se habla así de "ruido de cuantificación" que dependerá obviamente del número N de niveles empleados en el proceso. Cuantos más niveles existan menor será el ruido generado. La relación señal/ruido de cuantificación es:

![]()

De cuyo resultado se sacan las siguientes conclusiones:

Es evidente que usando codificación binaria resulta N=2m donde m=número de bits, por tanto:

![]()

La anterior ecuación es valida para la digitalización de una señal monocroma o para cada componente de color. Se adoptaron 8bits para la digitalización de la señal de video, por lo que la relación señal/ruido de cuantificación queda como:

![]()

Codificación. La codificación final de la señal de salida de un equipo depende de su aplicación. Puede usarse por ejemplo un código binario puro o un código de complemento a dos para aplicaciones locales. Pero cuando se trata de aplicaciones específicas, la codificación se convierte en un tema trascendente.

Formatos de codificación

Dos planteamientos aparentemente contradictorios se mantienen aún hoy día acerca de la digitalización de la señal de televisión en color:

La codificación de componentes.

Codificación de la señal compuesta Figura 35

Codificación de componentes Figura 36

Codificación de las señales compuestas. Esta propuesta consiste en digitalizar directamente las señales compuestas existentes (NTSC, PAL, SECAM). Con ello persiste el problema de la incompatibilidad de las distintas normas internacionales, aun manteniendo la misma frecuencia de muestreo y codificación. La decodificación devolvería las señales NTSC, PAL o SECAM, respectivamente.

La ventaja fundamental de digitalizar la señal compuesta radica en que el equipo puede incluirse como una unidad mas en los estudios análogos actualmente en servicio, sin necesidad de codificar o decodificar el NTSC, PAL o SECAM.

En la siguiente figura se muestra como opera el tratamiento de imágenes análogas durante la transición de la televisión análoga a digital, para el caso de codificación de señales compuestas.

Transición de análogo a digital de las señales compuestas Figura 36

Pasada la transición, la única ventaja que puede aportar la codificación de señales compuestas es el tratamiento de una señal única de video como ocurre actualmente en los Estudios análogos. Para los casos NTSC y PAL que modulan en amplitud a la sub portadora de color, el fundido, mezcla y encadenado corresponderá a una sencilla multiplicación de todas las muestras por un factor situado entre 0 y 1. Pero en el caso del SECAM, es necesario descomponer primero la señal de video en sus componentes Y, R-Y, B-Y antes de la mezcla. Este problema elimina esta ventaja para el SECAM.

Y en todo caso, cada fuente de video digital tendría que disponer de codificación y decodificación NTSC/PAL/SECAM, lo que representa una degradación de las imágenes por causa de los sucesivos procesos de codificación-decodificación. Así, se concluye que en el horizonte se encuentra la digitalización global de las señales en componentes.

Codificación en componentes. Por este método se digitalizan las tres señales Y, K1(R-Y), K2(B-Y) donde K1 y K2 son factores de ponderación que imponen el sistema digital. Estos factores no tienen los mismos valores que los coeficientes ponderados de NTSC, PAL o SECAM.

La primera y gran ventaja que se deriva de esta codificación es que siendo estas tres señales comunes a todos los sistemas, la compatibilidad puede alcanzarse por regulación internacional de los parámetros de muestreo, cuantificación y codificación. En tal sentido el CCIR (Comité Consultatif International des Radiocommunications o Comité Consultivo Internacional de Radio Comunicaciones) emitió en 1982 la norma 4:2:2 CCIR 601 de televisión digital en componentes.

La segunda ventaja de esta codificación es que una vez alcanzada la digitalización plena de la producción, sólo se requiere un paso final de conversión D/A y una codificación NTSC, PAL o SECAM según el sistema adoptado de transmisión. Se añade a las ventajas ya señaladas que el tratamiento digital en componentes elimina los efectos perturbadores mutuos de luminancia y crominancia a la vez que en edición electrónica desaparecen los problemas derivados de la estructura de 4 y 8 campos NTSC y PAL respectivamente. Sólo habría de tenerse en cuenta la estructura de dos campos entrelazados como en televisión en blanco y negro.

La norma CCIR 601 de televisión digital o norma 4:2:2. Esta norma define los parámetros básicos del sistema de televisión digital que aseguran la mayor compatibilidad mundial.

Se basa en una señal Y, Cr, Cb en el formato llamado 4:2:2 (4 muestreos Y por 2 muestreos Cr y 2 muestreos Cb), con una digitalización sobre 8 bits, con posibilidad de ampliarla a 10 bits para aplicaciones más exigentes.

Cualquiera que sea el estándar de barrido, la frecuencia de muestreo es de 13.5 MHz para la luminancia Y. Para las señales de crominancia Cr y Cb, dado su ancho de banda más limitado se muestrean a la mitad de la frecuencia de la luminancia, es decir, 6.75 MHz. Lo que se corresponde con una definición de 720 muestreos por línea en luminancia y de 360 muestreos por línea de crominancia, cuya posición coincide con la de los muestreos impares de luminancia. Ver la Figura 37.

Posición de los muestreos en el formato 4:2:2 figura 37

Para esta frecuencia de muestreo, el número de muestras por línea es de 864 y 858 para la luminancia y de 432 y 429 para las diferencias de color (sistema de 625 y 525 líneas respectivamente).

La estructura de muestreo es ortogonal, consecuencia de que la frecuencia de muestreo es un múltiplo entero de la frecuencia de líneas.

Las muestras de las señales diferencias de color se hacen coincidir con las muestras impares de la luminancia, o sea 1ª, 3ª, 5ª, etc.

El número de bits/muestra es de 8, tanto para la luminancia como para las señales diferencias de color, lo que corresponde a 28 niveles = 256 niveles de cuantificación.

La luminancia utiliza 220 niveles a partir del 16 que corresponde al nivel de negro, hasta el 235 correspondiente al nivel de blanco. Se acepta una pequeña reserva del 10% para la eventualidad de que ocurran sobre modulaciones.

Cuantificación de la señal de luminancia figura 37

Para las señales diferencias de color se utilizan 224 niveles, que se reparten a ambos lados del cero análogo, que se hace corresponder con el número digital 128. Así pues, la señal variará entre los valores extremos 128 + 112 = 240 y 128 112 = 16, con una reserva de 16 niveles a ambos lados.

Cuantificación de la señal de crominancia figura 38

Dado que las señales Cr y Cb están disponibles simultáneamente en cada línea, la definición vertical es idéntica tanto para luminancia como para crominancia, y se corresponde con el número de líneas útiles del estándar de exploración de partida (480 para el estándar de 525 líneas, 576 para los de 625 líneas).

El flujo bruto resultante es:

(13.5 x 8)+ (2 x 6.75 x 8) = 216 Mbit/s (270 Mbit/s con 10 bits)

Además, la digitalización de la parte útil de la señal de video solo requiere 166 Mbit/s, si se tiene en cuenta la inutilidad de digitalizar los intervalos de supresión del haz (también llamados "blanking") de línea y campo. Por tanto, estos tiempos libres pueden aprovecharse para transportar los canales de sonido digital, así como datos de servicio u otros.

A continuación se reproduce la norma 4:2:2 CCIR 601 en el Cuadro.

Parámetros de la norma 4:2:2

Parámetros |

Sistemas |

|

NTSC 525 líneas 60 campos |

PAL/SECAM 625 líneas 50 campos |

|

1. Señales codificadas |

Y, Cr, Cb |

|

2. Número de muestras por línea completa

|

858 429 |

864 432 |

3. Estructura de muestreo |

Ortogonal, estructura idéntica de todos los campos y cuadros. Las señales Cr y Cb se muestran simultáneamente con las muestras impares de la luminancia (1, 3, 5, etc.) |

|

4. Frecuencia de muestreo

|

13.5 MHz 6.75 MHz |

|

5. Codificación |

Cuantificación lineal. Codificación con 8 bits por muestra para la luminancia y cada señal de crominancia. |

|

6. Número de muestras activas por líneas digital:

|

720 360 |

|

7. Correspondencia entre los niveles de video y de cuantificación:

|

220 niveles de cuantificación. El nivel negro corresponde al número digital 16; el nivel nominal de blanco al número 235. 224 niveles de cuantificación en la parte central del margen de cuantificación. El nivel de video cero corresponde al número 128. |

|

Tabla 5

Ventajas del video digital. La calidad de reproducción de un sistema digital de video bien diseñado es independiente del medio y depende únicamente de la calidad de los procesos de conversión.

Cuando se copia una grabación digital, aparecen los mismos números en la copia: no se trata de un duplicado, sino de una clonación. Si no es posible distinguir la copia del original, no se habrá producido ninguna perdida en la generación. Las grabaciones digitales pueden copiarse indefinidamente sin que haya pérdida en la calidad.

Una de las mayores ventajas que presenta la tecnología digital es su bajo costo. Si la realización de copias no ocasiona perdidas de calidad, los equipos de grabación no tienen por qué ser mejor de lo necesario. No hay necesidad del consumo de cinta tan grande y costo excesivo que tienen los equipos de grabación análogos. Cuando la información que se ha de grabar adopta la forma de números discretos, estos pueden empaquetarse densamente en un soporte sin pérdida de la calidad. De darse el caso que algunos bits estén defectuosos por causa del ruido o de pérdidas de señal, el sistema de corrección de errores puede restituir el valor original. Las redes de comunicaciones desarrolladas para manejar datos pueden llevar perfectamente video digital acompañado también de audio a distancias indefinidas sin pérdidas de calidad. La difusión de televisión digital emplea estas técnicas para eliminar las interferencias, así como los problemas de atenuación de señales y de recepción de camino múltiple propio de las emisiones análogas. Al mismo tiempo, se hace un uso más eficaz del ancho de banda disponible. Los equipos digitales pueden llevar incorporados equipos de auto diagnóstico. El costo de mantenimiento se reduce.

24 FUNDAMENTOS DE LA COMPRESIÓN DE IMÁGENES

El término compresión de datos se refiere al proceso de reducción del volumen de datos necesarios para representar una determinada cantidad de información. Los datos son los medios a través de los que se transporta la información. Se pueden utilizar distintas cantidades de datos para describir la misma cantidad de información. Por lo tanto, hay datos que proporcionan información sin relevancia. Esto es lo que se conoce como redundancia de los datos. La redundancia de los datos es un punto clave en la compresión de datos digitales.

En la compresión digital de imágenes, se pueden identificar y aprovechar tres tipos básicos de redundancias:

La compresión de datos se consigue cuando una o varias de estas redundancias se reducen o se eliminan.

HISTOGRAMAS DE BRILLO